文章摘要(AI生成)

本文介绍了如何通过熟练掌握AI技巧和Prompt学习搭建LLM,以提高工作效率。具体包括技术方案设计、代码开发、测试、技术学习和答疑等方面。在使用GPT提效时,需要明确任务目标与意图,提供具体描述和上下文信息,分步指示,提供示例和模板,以及角色扮演式提问。此外,介绍了LLMChain的组件,包括PromptTemplate、语言模型和可选的输出解析器。通过这些方法和工具,可以更好地利用GPT提高工作效率。

作为橙序员,了解和使用当下技术趋势是必不可少的,尤其是已经火了大半年的GPT,如何使用GPT给日常工作提效,便很能体现我们对GPT的了解和使用能力。那么GPT可以为我们工作提高哪些效率呢?

熟用AI的技巧

熟练掌握Prompt

编写高效的提示词(Prompt)对于提高AI输出质量至关重要。让我为您介绍一些编写高质量Prompt的方法:

- 明确目标与意图:在编写Prompt时,首先要明确您希望AI完成的具体任务。例如,如果您需要AI编写一段代码,明确说明代码的功能、输入和输出要求

- 使用具体的描述:避免使用模糊的指令。具体的描述可以帮助AI更好地理解您的需求。

- 提供上下文:足够的上下文信息可以帮助AI理解任务的背景和细节。例如,在编写文档时,可以先简要介绍文档的主题和目标,再让AI生成具体内容。

- 分步指示:将复杂任务拆分为多个简单的步骤,每个步骤单独提供指令。这样可以减少AI的理解难度,提高任务完成的准确性。

- 示例和模板:提供示例和模板可以帮助AI更好地理解您的要求。

- 角色扮演式提问:通过让AI扮演不同的角色,可以模拟实际场景中的对话和互动,从而更真实地探讨问题、解决问题和回答提问者的问题。

学会搭建LLM

LLMChain是一个在语言模型周围添加功能的简单链,用于与 LangChain 库中的语言模型(LLM或聊天模型)进行交互。让我详细介绍一下 LLMChain 的组件:

PromptTemplate(提示模板):PromptTemplate是LLMChain的关键组件之一。- 它用于格式化用户输入,将输入变量填充到预定义的模板中,生成最终的提示。

PromptTemplate可以包含占位符,例如{product},用于接收用户提供的具体值。

- 语言模型(LLM或聊天模型):

LLMChain可以与不同类型的语言模型集成,例如大型语言模型(LLMs)或聊天模型。- 语言模型负责接收格式化后的提示,并生成相应的输出。

- 用户可以根据需求选择不同的语言模型,例如 GPT-3.5 Turbo 或其他自定义模型。

- 可选的输出解析器:

- 输出解析器是一个可选组件,用于处理语言模型的输出。

- 它可以将模型生成的文本进行解析、过滤或后处理,以满足特定需求。

- 如果不需要特定的后处理步骤,可以省略输出解析器。

如何使用GPT提效?

技术方案设计

技术方案设计中,我们既要根据现状梳理改动点,又要为改动点配之对应的流程图便于理解。这里涉及到两个方面,一个是基于系统现状的知识库搭建,一个是可以根据文字生成流程图。

我们先看文字生成流程图的过程,我们可以借助现有的工具,例如妙办画板:

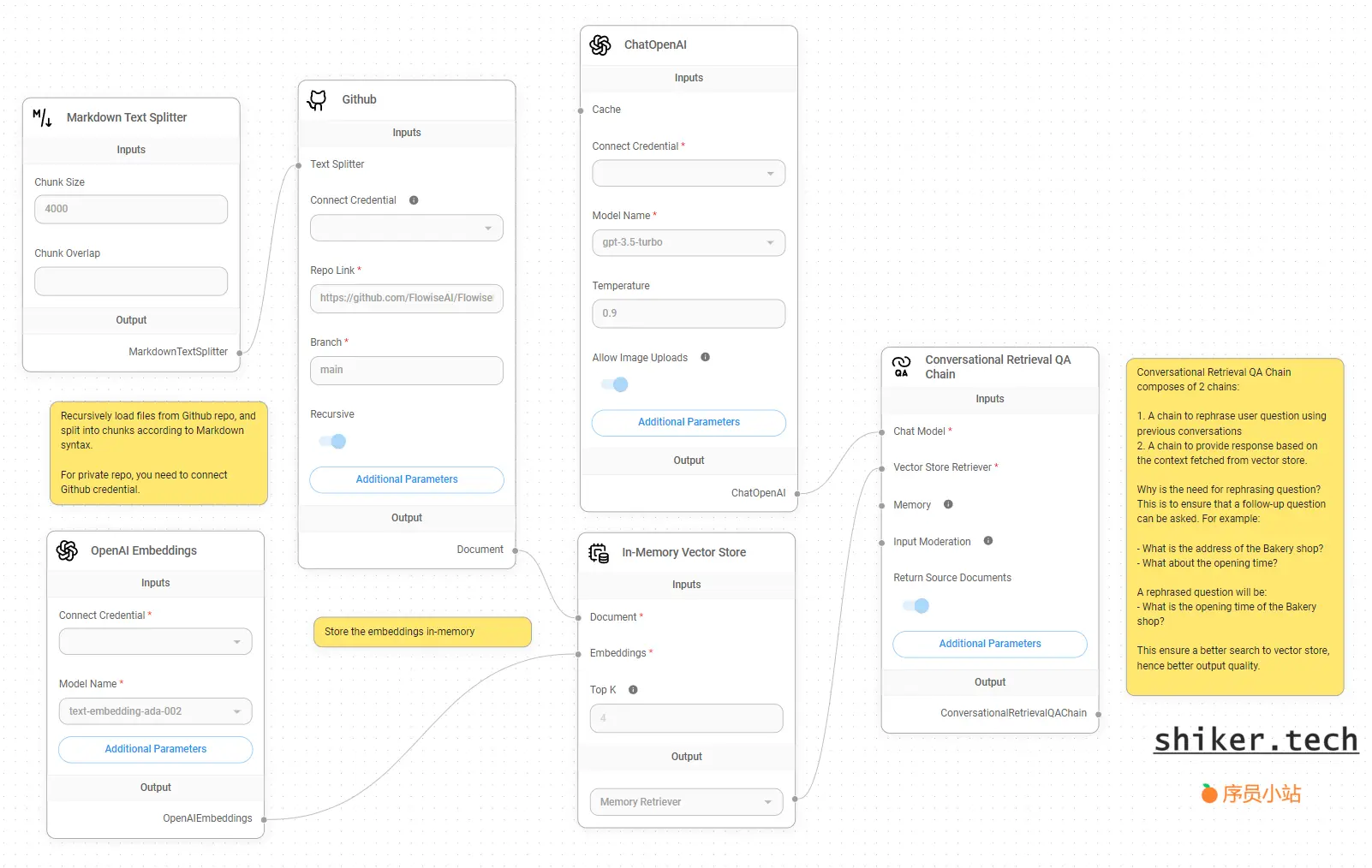

在知识库搭建方面,我们可以以数据库、仓库为知识库底层数据源,然后基于LLM搭建一个知识库问答助手:

代码开发测试

这方面对应的GPT助手就更多了,国内的有通义灵码、MarsCode、CodeFuse,国外有Copilot、CodeWisper等。如果可以使用国外助手,优先选用国内或公司内部。国内来说通义灵码推出较久,功能也较为齐全,其他编程助手优化、内容等方面都有使用问题,所以会一定程度降低效率,所以不推荐。

技术学习答疑

这里分为两种,一种是学习新技术,一种是已有技术问题解答,前者一般是思路指南,使用chat gpt更容易找到学习方向,比如你想要学习摄影:

后者更借助于搜索,来解答现有的技术问题,例如排查连接超时问题:

评论区